DirectX SDK August 2009 が出ています。

ついに Direct3D 11 の RTM 対応となりました。

・DirectX SDK (August 2009)

D3D11 自体は Windows 7 や Windows SDK for Windows7 で RTM 版が出ています。

デバッグ向けライブラリや D3DX、ツールを含んだ SDK としてはこれが最初です。

これで安心して Windows7 RTM 環境へ移行できそうです。

●大きなトピック

予想通りベータ版で欠けていた機能が追加されました。

例えば

・Effect (fx)

・BC6/7 対応コンバータ

特に Effect はベータに入っていてもおかしくない大きなコンポーネントです。

もしかして SDK のリリースが遅れた原因もこのあたりでしょうか。

マニュアルの完成度は高く、大幅に更新されているようです。

ドキュメントも March SDK で足りなかった各項目が埋まっており、説明も増えて結構

力が入っています。かなり好印象です。

また今回新たに明らかになった点もいくつかあります。特に次の 2つ

● FeatureLevel 9_3 は ShaderModel 2.0 だった

最初マニュアルの表記ミスかと思いました。

CapsViewer でも確かに 2.0 と表示されるので間違いではないようです。

11_0 sm5.0

10_1 sm4.1

10_0 sm4.0

9_3 sm2.0 (4_0_level_9_3) << ここ

9_2 sm2.0 (4_0_level_9_1)

9_1 sm2.0 (4_0_level_9_1)

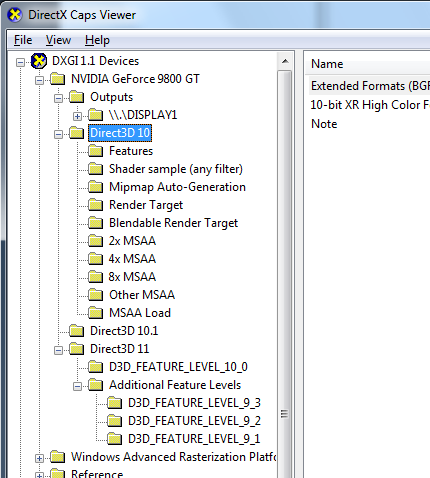

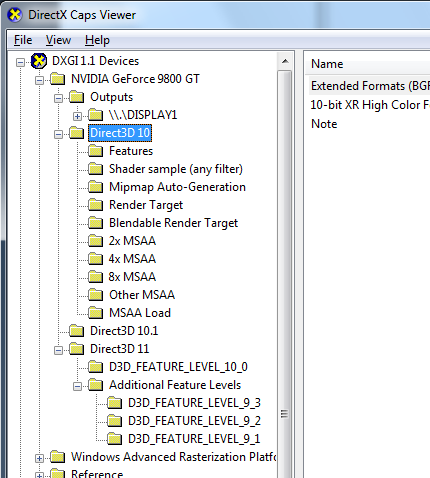

● CapsViewer が復活した!!

FeatureLevel 登場時から結局 caps と同じことではないかと心配しましたが、

今回のリリースではそれを正式に認めたようなもの。

本当に CapsViewer に組み込まれてしまいました。

DXCapsViewer.exe を起動すると DXGI 1.1 Devices の欄が追加されています。

それぞれの FeatureLevel 毎に対応機能やフォーマットなど、各ドライバの対応状況を

確認することが出来ます。

●D3DCSX が追加された

D3DX の ComputeShader 版です。prefix は D3DX のまま。

D3DX*.dll, D3DCompiler*.dll のように、番号付きの dll が今後追加されていく

ことになるようです。

●バージョンと互換性

SDK のメジャー番号は 9 のままです。

厳密には DirectX 9 SDK の中に Direct3D 10 や Direct3D 11 が含まれている

扱いになります。とはいえ、便宜上 DirectX 11 と表記することも多いです。

DirectX だけでなく Direct2D や DirectWrite も含まれています。

Vista でも動作します。

●ID3D11DeviceContext の更新

・追加

ID3D11DeviceContext::CopyStructureCount()

・削除

ID3D11DeviceContext::GetTextFilterSize()

ID3D11DeviceContext::SetTextFilterSize()

以前 DebugLayer が動かなかった原因はこの辺にありそうです。

● D3D11_PRIMITIVE の追加

enum D3D11_PRIMITIVE が追加されています。

似たようなシンボルとしてすでに D3D11_PRIMITIVE_TOPOLOGY が存在しています。

定義を見ると STRIP 形式が外されているようです。D3D11_PRIMITIVE は唯一

D3D11_SHADER_DESC の中で用いられています。考えられる用途は下記の通りです。

・D3D11_PRIMITIVE_TOPOLOGY ( strip あり )

IA や SO など strip 形式を含めたプリミティブの指定。

・D3D11_PRIMITIVE ( strip 無し )

GeometryShader / HullShader など、頂点ストリームやキャッシュを通過し、

Triangle (Primitive) 単位で入力が必要なシェーダーの指定で用いる。

● BC6H/BC7 texture

新しい圧縮テクスチャフォーマットです。繰り返しになりますが、従来 DXT と

呼ばれていたフォーマットは Direct3D 10 より BC に名称が変わっています。

BC1 4bpp ← DXT1

BC2 8bpp ← DXT2/3

BC3 8bpp ← DXT4/5

BC4 4bpp ← 1チャンネル圧縮

BC5 8bpp ← 2チャンネル圧縮, 法線圧縮 (3Dc/ATI2)

BC6 8bpp ← (BC6H_UF16, BC6H_SF16)

BC7 8bpp ← (BC7_UNORM, BC7_UNORM_SRGB)

付属のコマンドラインツール texconvex.exe を使うと実際に BC6H/BC7 で圧縮できる

ようになりました。DxTex.exe などそれ以外のツールは Direct3D 9 のテクスチャしか

扱えないので要注意です。

実際に試しましたが、圧縮は非常に低速です。

最初 1600×1200 のデータを渡してしまってかなり後悔しました。

結局中断して 640×480 でやり直したくらい。それでも結構待たされています。

Core i7 920 なのに。

リファレンスデバイスを指定したアプリを作れば一応読み込むことが出来ました。

ただデータの一部が化けており正しく出ていない可能性があります。

DXT10 形式の dds データ化けは以前もあったので、使い方のミスかツール側の

問題かもしれません。

DXT10 ヘッダを追加した dds テクスチャは D3D10 で登場したものの、対応したツール

はまだあまり出ていません。128byte + 20byte と中途半端なヘッダサイズになって

しまうため、一括ロードだと SSE 対応も難しいという欠点があります。

●残るは GPU (とドライバ)

とりあえず 9_3 の Shader Model 2.0 と、DXCapsViewer には驚きました。

Direct3D 8 の改革が Direct3D 9 で完成したように、

Direct3D 10 で目指したものの完成形が Direct3D 11 だといえるでしょう。

手持ちのコードは March 2009 から Direct3D 11 に移行しましたが、互換性も取れる

ようになったし、かなり使いやすい印象です。

あとは対応 GPU が発売されるのを待つばかり。

関連エントリ

・Direct3D11 Windows7 RTM と DebugLayer

・Direct3D11/DirectX11 ComputeShader 4.0 を使う

・DirectX SDK March 2009

・Gamefest2008 と Direct3D 11

・Direct3D10 と DDS テクスチャフォーマット