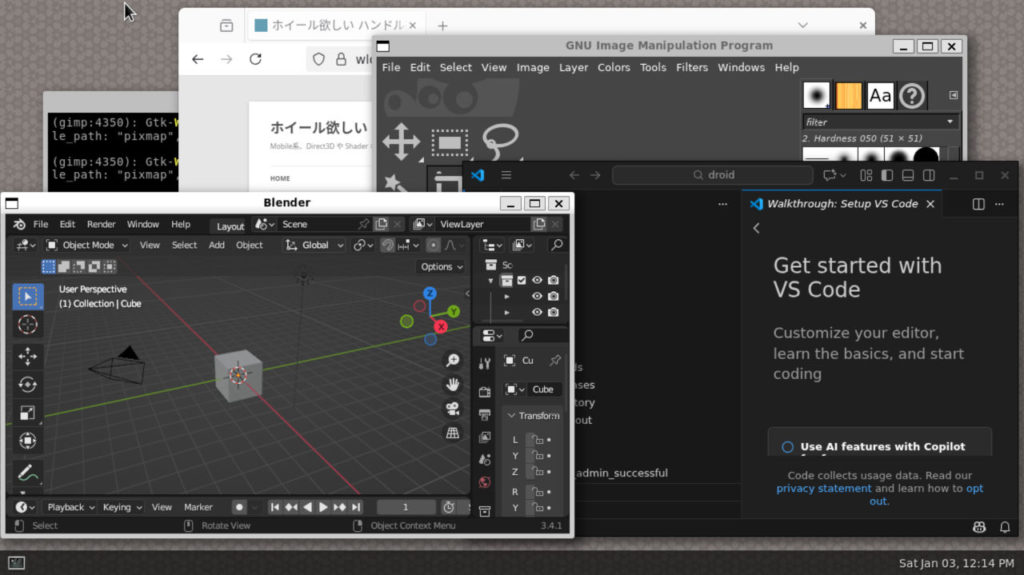

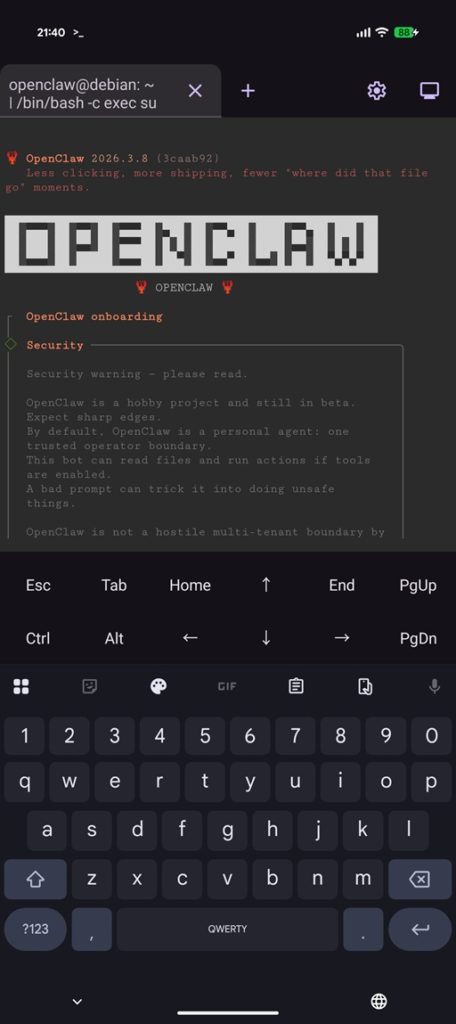

Google の Pixel スマートフォンには標準で Linux のターミナル機能が入っています。これを使って AI エージェントの OpenClaw を走らせてみました。もし機種変更などで使わなくなった Pixel スマートフォンがあるなら、持ち運べる OpenClaw マシンを作ることができるかもしれません。

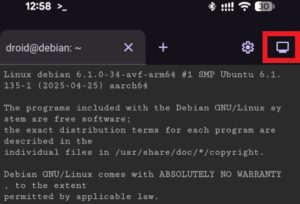

この画面は Pixel 9a 実機上のものです。

以下はその手順です。

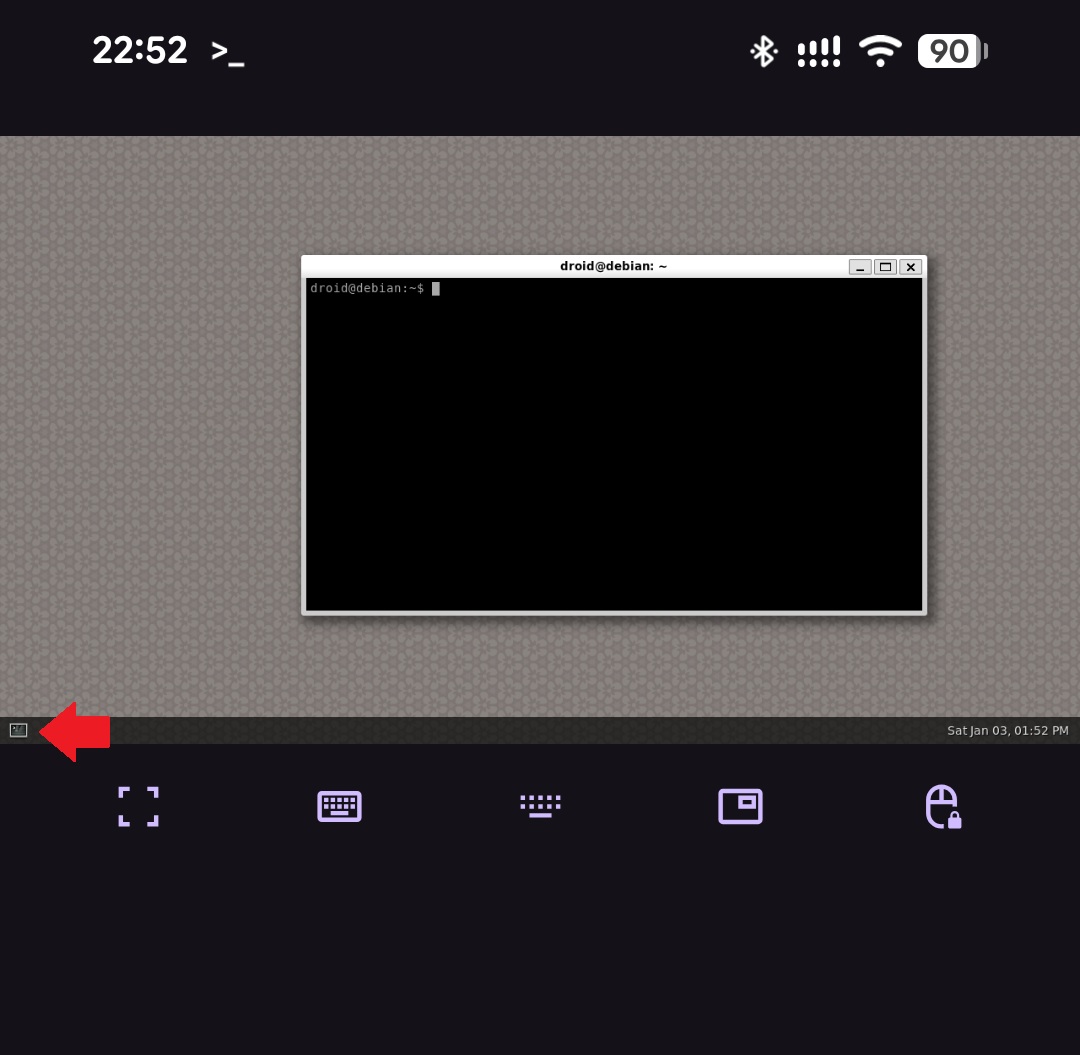

(1) Linux ターミナル (Linux 開発環境) を有効化する

有効化手順は過去にも何度か解説してますので興味ある方はそちらもご覧ください。

先に Display のスリープ時間を 30分に設定しておくことをお勧めします。インストール途中でスリープして止まってしまうのを防ぐためなので、完了したら元の値に戻しておいてください。

コマンド入力は USB or Bluetooth のキーボードがあると便利です。もしくは少々設定の手間が必要ですが、ssh を使って PC からログインして作業することもできます。(tailscale や termux の設定、/etc/ssh/sshd_config の PasswordAuthentication を yes に変更等)

- 画面自動消灯の時間を 30分に変更

- 設定 → ディスプレイとタップ → 画面自動消灯 → 30分を選択

- ※ インストールが完了したら元の時間に戻しておいてください

- 開発者向けオプションを有効化

- 設定 → デバイス情報 → ビルド番号 の欄を 7回タップ

- 開発者向けオプションから Linux ターミナルを有効化

- 設定 → システム → 開発者向けオプション → Linux開発者環境 (試験運用版) を有効化

- これで Pixel に「ターミナル」アプリが追加されます

- Linux のインストール

- 「ターミナル」アプリを起動して「インストール」をタッチ

- ホーム画面には自動的に追加されないので、アプリケーションドロワーから「ターミナル」のアイコンを探してください

- インストールにはしばらく時間がかかるのでターミナルが起動するまで待ちます

- ターミナルが起動したら以下のコマンドを実行します

sudo apt update

sudo apt upgrade -y

sudo apt install systemd-container(2) OpenClaw 用のユーザーを作る

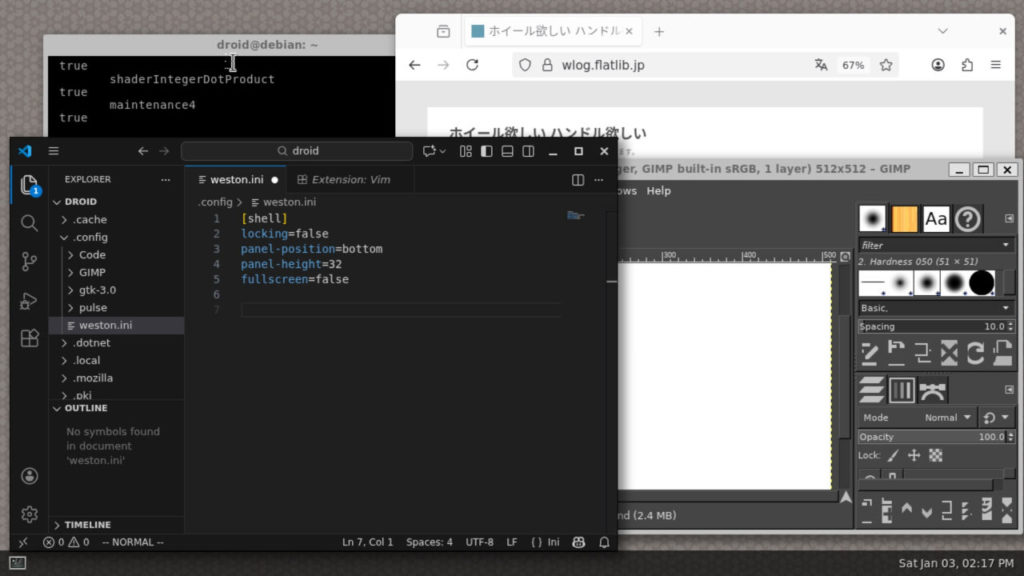

ターミナルアプリのデフォルトユーザーは droid ですが、Android の内部ストレージから隔離するためにユーザーを分けてみます。新たに openclaw というユーザーを作ってそちらでインストールします。以下のコマンドを実行し、パスワードを登録したらあとは全部 Enter。

sudo adduser openclaw以下のコマンドを実行してユーザーの権限を設定します。users group から削除しているのは内部ストレージ ( /mnt/shared ) にアクセスできないようにするためです。

sudo gpasswd -a openclaw sudo

sudo gpasswd -d openclaw usersデフォルトの droid ユーザーのパスワードは “droid” が入っているので、パスワードを変更しておきます。以下のコマンドで droid ユーザー用の新しいパスワードを設定します。

sudo passwd droidOpenClaw 用のユーザーに切り替えるには以下のコマンドを使います。パスワード入力が必要です。最初は su を使っていましたが systemctl –user でエラーになります。

sudo machinectl shell openclaw@.hostユーザー切り替え後に、プロンプトが ‘$’ 1文字だけの場合は sh が動いているので手動で bash を実行します。

bash(3) OpenClaw をインストールする

最初にユーザーを “openclaw” に切り替えておいてください。( sudo machinectl shell openclaw@.host )

あとは通常の Linux 版の OpenClaw のインストール手順そのままです。公式サイトにあるように以下のコマンドを実行します。ここでは 2026/03/07 版で手順を解説していきます。

なお連携用の各種 API Key や token は予め PC 上で用意しておくことをお勧めします。

curl -fsSL https://openclaw.ai/install.sh | bash- 「I understand this is personal-by-default and shared/multi-user use requires lock-down. Continue?」

- Yes を選択

- 「Onboarding mode」

- QuickStart を選択

- 「Model/auth provider」

- もし API Key を持っている物があるなら選択して指示に従ってください。

- ここで設定せずにあとから登録する場合は「Skip for now」→「openai」→「Keep current」の順で選択します。

- 「Select channel (QuickStart)」

- もしここで Discord や Slack 等の設定を行う場合は選択して指示に従ってください。Bot アプリの設定が必要なので、先に PC 上で作業して token を用意しておくことをお勧めします。

- ここで設定せずにあとから登録することもできるので、その場合は「Skip for now」を選んでください。

- 「Search provider」

- Web 検索サービスを選択できます。

- こちらも特に API Key を持っていない場合は「Skip for now」で構いません。

- 「Configure skills now? (recommended)」

- Yes を選択

- 「Install missing skill dependencies」

- スペースキーで選択してから Enter で進みます。

- 特になければ「Skip for now」を Space キーで選択してから Enter

- 「Set GOOGLE_PLACES_API_KEY for goplaces?」

- 以下、特にキーがなければ全部 No で構いません。

- 「Enable hooks?」

- “Skip for now” を Space キーで選択してから Enter

- 「How do you want to hatch your bot?」

- Do this later を選択

これでインストールは完了です。最初は openclaw コマンドにパスが通っていないので、以下のコマンドを実行しておいてください。

. ~/.bashrc(4) インストール手順でスキップした設定を行う

インストーラーの手順でスキップした場合でも、任意のタイミングで設定を行うことができます。最初の選択肢は「Local (this machine)」を選んでください。

使用する LLM Model の選択

openclaw configure --section modelWeb 検索用の API 設定

openclaw configure --section webDiscord, Slack などのメッセージングアプリとの接続

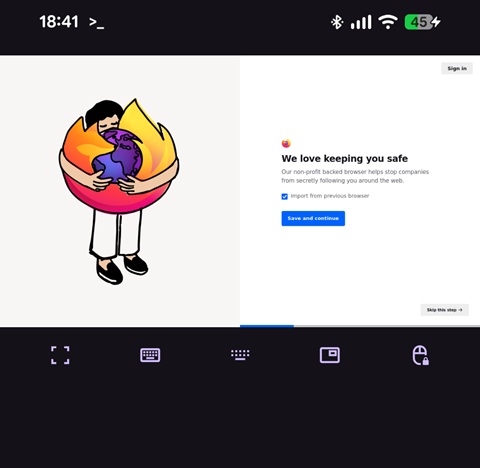

openclaw configure --section channel↓これは Pixel9a 上で動いている OpenClaw に Pixel9a 上の Discord から接続したものです。(LLM は外部サービス)

(5) その他の設定

一通りインストールが終わったら画面の自動消灯設定をもとに戻します。

- 設定 → ディスプレイとタップ → 画面自動消灯 → 元の値に戻す (30秒などに)

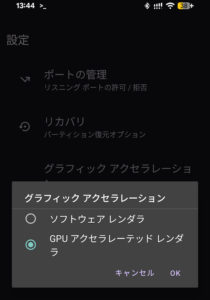

念の為以下の設定もしておきました。

- 設定 → システム → 開発者向けオプション → 子プロセスの制限を無効化を ON

その他 OpenClaw 側の設定などは以下のページでも解説していますのでもしよろしければ参考にしてください。

動作したあとの問題解決など

一度動作してしまえばあとは OpenClaw 自身に問題解決してもらうことができます。openclaw status 実行時に何らかの Warning や Error が出ていた場合は、直接チャットに送って修正を依頼します。

注意点&使ってみて

メモリを消費する重いアプリケーションを立ち上げるとバックグラウンドのタスクが停止させられてしまう可能性があります。もしできるだけ安定して起動状態を維持したい場合は、Linux のターミナルをフォアグラウンドにして Pixel の直接操作を控えた方が良いかもしれません。

バックグラウンドプロセスの停止を防ぐ設定として Phantom Process Killer の無効化 があります。長時間安定して稼働させたい場合はこちらの設定もしておくことをお勧めします。設定には PC からの adb 接続が必要です。またバッテリー消費量が増えますのでご注意ください。

一日ほど持ち歩いてみましたが Sleep 状態でも OpenClaw 自体はきちんと動作しています。ただし安定動作するとは限らないので、利用時はこまめにバックアップを取って置くことをお勧めします。基本的には ~/.openclaw 以下 (/home/openclaw/.openclaw 以下) をまるごと保存しているだけです。

しばらくして一度コマンド実行ができず不安定になったことがありましたが、この場合スマートフォン本体の再起動で復帰しました。調子が悪くなった場合でもターミナルアプリの強制終了は避けてください。

バックアップ手順の例

user openclaw 側で

cd

tar -zcvf /tmp/backup.tgz .openclawuser droid 側で

cp /tmp/backup.tgz /mnt/shared/Download/本体ストレージの Download フォルダに入ります。

復元時は OpenClaw を新規インストール後に .openclaw フォルダをバックアップ時のものに置き換えてから openclaw –fix を実行します。