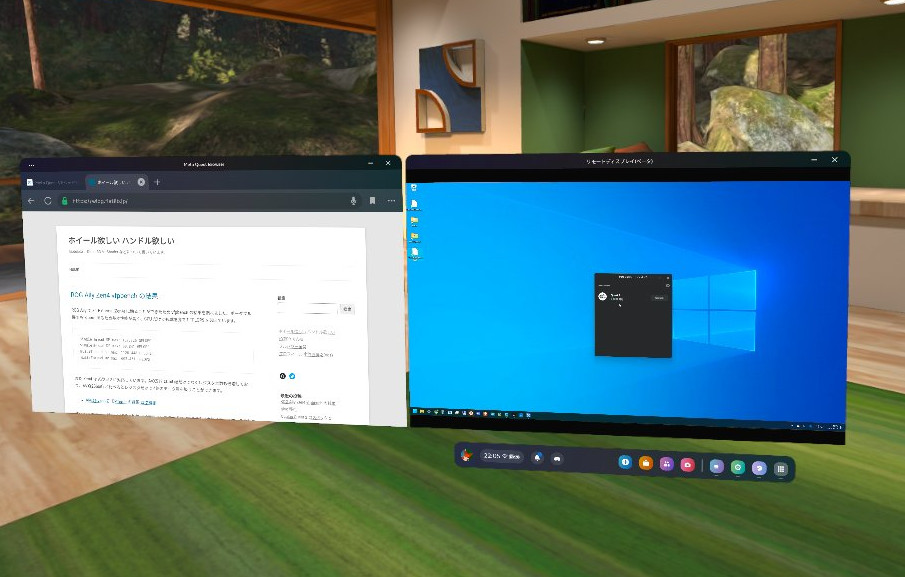

SteamDeck の最新の OS には最初から Distrobox がプリインストールされており、簡単に Ubuntu などの環境を入れられることがわかりました。前回の vfpbench は SD-Card から起動した Windows11 上で走らせましたが、今回は SteamOS 上でそのまま実行できるように Ubuntu を入れてみます。

● デスクトップの設定

以降の一連の作業は USB Hub 経由で SteamDeck に USB のキーボードとマウスを接続した状態で行っています。Bluetooth のキーボード&マウスでも構いません。

(1) デスクトップに切り替える

- STEAM ボタン → 電源 →「デスクトップに切り替え」

元のゲーミングモードに戻るには、デスクトップ左上の「Return to Gaming Mode」のアイコンダブルクリックかログアウトを行います。

(2) キーボード配列を日本語に変更する場合

- 左下の Application Launcher アイコンクリック→ Settings → System Settings

- 一番上の Keyboard → Layouts Tab を開く

- 「Configure layouts」にチェックを入れる → 「+ Add」をクリック

- “Japanese” で検索して「Japanese (OADG 109A)」を選択

- デフォルトで入っている「us English (US)」を選択して「- Remove」をクリック

- 右下の「Apply」をクリック

(3) 表示言語を日本語に変更する場合

- 左下の Application Launcher アイコンクリック→ Settings → System Settings

- Regional Settings → Language 右端の「Modify…」

- 「Change Launguage」→「日本語」を選択→右下の「Apply」→右上の「Restart now」→「OK」

- 再起動後、ゲーミングモードになっている場合は再び STEAM→電源→「デスクトップに切り替え」

● Distrobox で Ubuntu をインストールする

Distrobox / podman 自体のインストール手順は不要です。公式 Image を使ってクリーンインストールした状態でも /usr/bin にコマンドが含まれていることを確認しました。

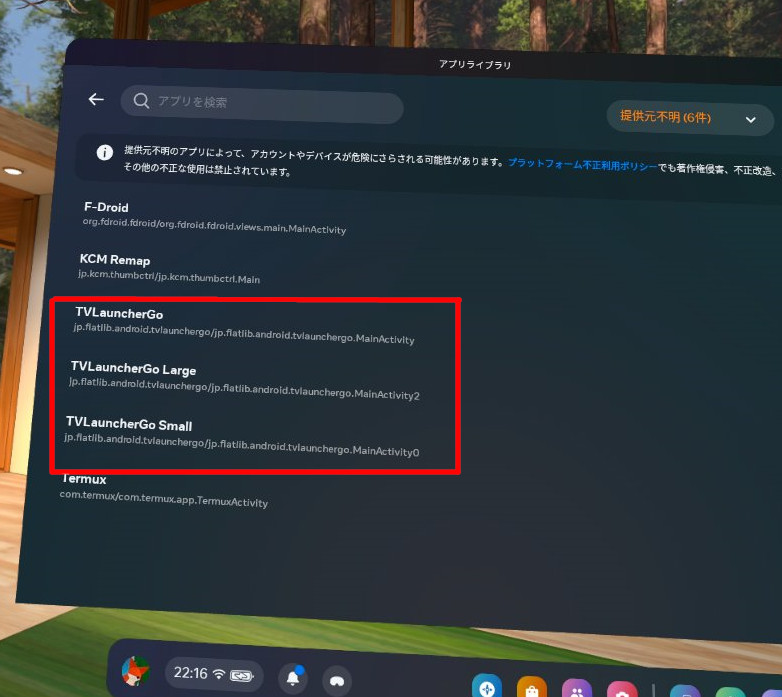

- 左下の「アプリケーションランチャー」アイコンクリック → システム→ Konsole (KDE Terminal) でコンソールを開く

- 以下内容で ~/.distroboxrc ファイルを作成します

xhost +si:localuser:$USER

export PIPEWIRE_RUNTIME_DIR=/dev/null

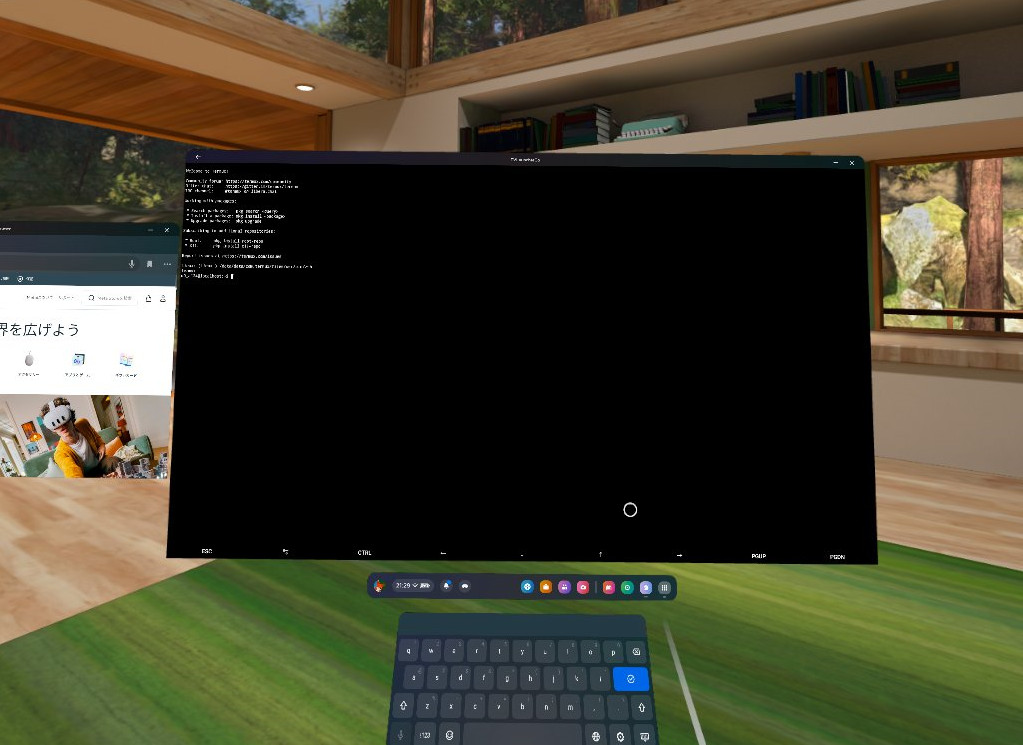

- コンソールで以下のコマンドを実行

$ distrobox create -i ubuntu:22.04

Do you want to pull the image now? [Y/n]: に Y を入力

- 以下のコマンドを実行

$ distrobox enter ubuntu-22-04

以後、4. のコマンドだけで Ubuntu 環境に入ることが可能です。またはアプリケーションランチャーからも直接「Ubuntu-22-04」のアイコンを探して起動することができます。

● Ubuntu 環境の設定など

あとは Ubuntu 上で apt コマンドを使ってソフトウエアのインストールができます。

例 vfpbench のために git, clang を入れる

$ sudo apt update

$ sudo apt upgrade -y

$ sudo apt install -y git clang

例 vim + uim-mozc を使った日本語入力を行う場合

- ソフトウエアをインストールします

予め (3) の日本語表示設定をしておく必要があります。

$ sudo apt install vim

$ sudo apt install language-pack-ja

$ sudo apt install uim-fep uim-mozc

- 以下の内容で ~/.uim ファイルを作成しておきます。

(define default-im-name 'mozc)

(define-key generic-on-key? '"<Control> ")

(define-key generic-off-key? '"<Control> ")

- 起動します

$ export LANG=ja_JP.UTF-8

$ uim-fep

例 vscode を使う

- https://code.visualstudio.com/Download から 「.deb」「x64」 をダウンロードしておきます。

- 以下のコマンドでインストール&起動します

$ sudo apt install ./code_~_adm64.deb

$ code

活用など

SteamDeck の SteamOS はスマートフォンのように電源ボタンで簡単にスリープ可能で復帰も安定しています。持ち歩ける開発環境として便利に使えそうです。

関連エントリ